STM32N6 AI生态与开发实战指南

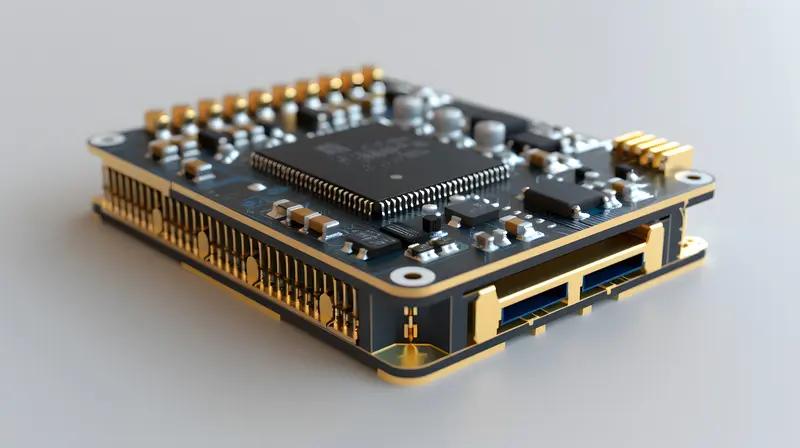

STM32N6系列是意法半导体专为边缘AI设计的微控制器,基于Arm Cortex-M55内核,主频高达800MHz,集成Helium向量处理技术,具备先进的数字信号处理能力。它还内置自主研发的Neural-ART加速器NPU,运行频率1GHz,算力可达600GOPS,能以低功耗实现实时AI推理,适用于视觉、音频及多模态任务。同时,STM32N6配备专用计算机视觉流水线,支持ISP和MIPI CSI-2接口,还有H264编码器、JPEG编解码器等多媒体硬件功能,适合需要图像、视频处理的AI应用。

为支持STM32N6的AI开发,意法半导体构建了完整的软件生态。核心包括STM32 Model Zoo,这是预训练AI模型集合,涵盖图像分类、目标检测、姿势估计等常见任务,每个模型都经优化可直接在STM32N6上运行,还有训练、量化、部署的Python脚本,方便快速原型设计。另外,STM32 Model Zoo Service仓库提供更多辅助脚本,比如模型评估、后处理工具,支持一键生成部署代码。Hugging Face仓库则存放着ST公开论文的模型文件和指标,供开发者参考。

工具链方面,ST Edge AI Suite整合多种工具简化流程。STM32Cube.AI是STM32CubeMX插件,能将Keras、TensorFlow、ONNX等框架的模型转换为STM32优化的C代码;ST Edge AI Developer Cloud是在线平台,可在托管的STM32开发板上测试AI性能(推理时间、内存占用),还能自动生成代码;ST Edge AI Core是命令行工具,支持模型优化和代码生成。这些工具都能充分发挥NPU潜力,确保AI应用高效运行。

STM32N6的AI应用包覆盖多个场景。音频类有音频事件检测(AED)和语音增强(SE),前者分类音频场景,后者用于降噪;视觉类包括图像分类(基于MobileNet模型,支持IMS335、ST全局快门摄像头)、目标检测(YOLO系列模型)、姿势估计(Coco Person数据集,支持YOLO V8/V11替换)、实例分割(YOLO V8/V11)、语义分割(DeepLab V3,21类别像素级分割)、手部关键点检测(SDE Yolo+关键点模型);还有视频应用,比如结合H264编码和USB UVC流,将数据输出到PC。部分应用还优化了FreeRTOS操作系统,适合多任务场景。

对于开发者,STM32N6570-DK开发板是体验AI功能的常用载体。实际开发需准备STEdgeAI、STM32CubeIDE、STM32CubeProgrammer、arm-none-eabi-objcopy等工具,并添加到环境变量。还要下载STM32N6 Getting Started、STM32 Model Zoo Services、stm32ai-modelzoo等资源包。Python环境建议用Anaconda创建虚拟环境,安装requirements.txt里的依赖库,避免包冲突。接下来配置YAML文件,修改模型、数据集、工具路径等信息,比如object_detection目录下的config_file_examples有现成模板。然后运行stm32ai_main.py脚本生成模型代码,注意不同版本的脚本路径差异(3.1.0版本在object_detection目录,3.0.0在object_detection/src)。生成的模型文件如果没有hex格式,可用命令转换:arm-none-eabi-objcopy -I binary network_atonbuf.xSPI2.bin --change-addresses 0x70380000 -O ihex network_data.hex。烧录时需将开发板BOOT0开关拨到右边,进入dev模式,先烧录引导程序,再烧录network_data.hex。

意法半导体的GitHub仓库是开发者重要资源,STMicroelectronics账号下有400多个仓库,每天更新,比如STM32Cube系列包含HAL库、例程、中间件,X-CUBE-AI专门用于AI推理,TouchGFX适合做图形界面。这些仓库能快速找到新芯片的例程,比官网更新更及时,是嵌入式开发的实用工具库。